Monica Schoonhoven, Global Director of Customer Success bij Textkernel, legt in deze blogpost uit met welke zaken je rekening moet houden bij het identificeren van transparantie met betrekking tot AI.

Kijkend naar hoe Large Language Models (LLMs), een vorm van generative AI die in staat zijn om tekst te begrijpen en te genereren (zoals ChatGPT), ontwikkeld worden, is dat, net als bij andere AI modellen, nog steeds met data waarmee ze getraind worden.

Elk model wordt getraind met een set data. En de trainingsset voor LLM’s is groter dan ooit. Dat komt onder andere doordat het verwerken van data sneller gaat en er veel meer rekencapaciteit is. Waar 5 jaar geleden een model werd getraind op enkele honderden tot duizenden documenten, zijn LLM’s tegenwoordig getraind op een groot deel van het complete internet, wat wil zeggen dat ze dus van veel meer data hebben kunnen leren. Echter is het belangrijk om te beseffen dat er altijd menselijke input is bij het ontwikkelen van LLM’s.

Transparantie in AI: waar eindigt het?

Door de vooruitgang van de technologie en een hogere verwerkingssnelheid, zien we de redeneringen van LLM’s , ten opzichte van traditionele AI, veel complexer worden, legt Monica uit. “LLM’s zijn niet per definitie ingewikkeld, maar ze hebben veel meer diepte. Zo kunnen ze beter interpreteren wat een bepaalde vraag betekent of kunnen ze meerdere bronnen tegelijkertijd combineren tot een helder antwoord.”

Daarnaast is de output die LLM’s leveren steeds meer gaan lijken op een menselijke vorm van communiceren. Monica: “Denk hierbij aan het aanbrengen van een bepaalde communicatiestructuur, vriendelijkheid en omgangsvormen in verschillende talen.” Die elementen zorgen ervoor dat de input, het verwerken van die input én de output geavanceerder zijn dan ooit. “En daarmee zie je ook dat de zorg over een aantal facetten – waar komt iets vandaan, waarom wordt een bepaald antwoord gegeven, is het antwoord van ‘de mens’ of ‘een computer’ – steeds minder duidelijk is.”

Monica vervolgt: “De hamvraag is dus eigenlijk: ‘Waar eindigt dit?’ De transparantie is nu al een beetje in het geding en bij onverantwoordelijk gebruik van AI kan de transparantie volledig verloren gaan.”

De AVG legt de focus op welke data je mag gebruiken, terwijl het in de EU AI Act gaat over hoe je deze data gebruikt.

Monica Schoonhoven, Global Director of Customer Success

EU AI Act moet transparantie waarborgen

Om transparantie in AI te kunnen garanderen en ervoor te zorgen dat AI geen maatschappelijke schade kan berokkenen, is de EU AI Act in het leven geroepen. In Europa is het vooral de bedoeling om het vertrouwen in AI technologie te bevorderen. Maar daarnaast is het tevens het doel om burgers te beschermen tegen de impact die AI wellicht kan hebben. Het aannemen van de EU AI Act is recentelijk gebeurd, dus over alle specifieke implicaties en de exacte uitvoering van de wet is nog niet alles bekend.

Monica: “Als we kijken naar EU AI Act, is het heel aannemelijk dat de processen omtrent recruitment als High Risk AI zullen worden aangemerkt. De regels die daarbij gaan gelden zijn op de volgende gebieden: transparantie en nauwkeurigheid, risicoanalyse, logboeken bijhouden, menselijk toezicht en recht op klacht en uitleg.”

Het Europees Parlement vindt het ontzettend belangrijk dat bedrijven, die met AI werken, inzicht en transparantie geven, om er op die manier voor te zorgen dat de burger blijvend wordt beschermd.

Transparantie toepassen in de praktijk

De belangrijkste vraag is dan hoe je dit toepast in de praktijk. Hoe kun je checken of de AI technologie die je gebruikt of wilt gaan gebruiken ook daadwerkelijk aan de EU AI Act voldoet. “De exacte spelregels zijn nog niet bekend”, legt Monica uit. “Maar er zijn al wel drie hele duidelijke items die je aan je AI technologieleverancier kan aankaarten rondom het identificeren van transparantie. Textkernel is jaren geleden al begonnen met het concept ‘Responsible AI’, omdat het niet alleen belangrijk is dat we voldoen aan de (toekomstige) regelgeving, maar dat we ook intrinsiek gemotiveerd zijn heel scherp te blijven op transparantie in recruitmentprocessen, terwijl we ook blijven innoveren.” Hieronder gaat Monica in op zaken waar je rekening mee moet houden bij het identificeren van transparantie met betrekking tot AI: gegevens, representativiteit en updates.

De data

Welke data wordt er gebruikt? Zoals gezegd, elk AI model is getraind op data. En omdat we het over kandidaten en hun informatie hebben tijdens recruitmentprocessen, is het belangrijk om hierbij ook naar de AVG te kijken. Want waar de AVG de focus legt op welke data je mag gebruiken, gaat het in de EU AI Act erover hoe je deze data gebruikt.

Daarnaast is de juistheid van die data heel belangrijk. Past de data die je het systeem voedt om te leren ook daadwerkelijk bij de taak voor de output. Verificatie van data is bij dit punt ontzettend belangrijk. Is het in de juiste taal, is de data ‘schoon’ en passend voor de beoogde toepassing? Maar ook hier geldt: meer data is niet per se beter. Je kan bijvoorbeeld beter een kleinere set met precies de juiste input hebben, zodat het resultaat ook accurater wordt. Dus soms geven LLM’s, die op het ‘internet’ is getraind, juist minder goede resultaten dan ‘Not-So-Large Language Models’ , door bijvoorbeeld semi-handmatige gecontroleerde, kleinere volume input data set.

Representativiteit is ook een belangrijk element, omdat bij dit punt ook de grote zorg omtrent vooroordelen (of bias) zit. Het is belangrijk om te zorgen dat trainingsdata een diverse en gebalanceerde representatie van de bevolking is. Als dit niet het geval is, kunnen bepaalde groepen benadeeld worden door het algoritme. Zorg ervoor dat je weet waar de data vandaan komt. Een van de elementen die hierbij helpt, en dat doen we bij Textkernel ook, is om een AI Fairness Checklist te maken. Daarmee creëer je bepaalde standaarden waaraan je jezelf kunt houden. Zo heb je sneller inzicht in waar de data vandaan komt en wat voor data er in je trainingsset zit. Je kunt er dan ook meteen voor zorgen dat alle eventuele vooroordelen in de input verdwijnen.

Als laatste element zijn de updates heel belangrijk. Hoe zorg je ervoor dat je continu blijft voldoen aan de nieuwste regels en welke processen zijn daarvoor afgesproken? Een AI model is zo oud als de data die erin gestopt is. Voor sommige processen is een jaar oude data eigenlijk al te oud, denk hier bijvoorbeeld aan functie- en skills-ontwikkelingen.

De eerder genoemde AI Fairness checklist maakt binnen Textkernel deel uit van een groter Risk Management Framework (RMF), dat nu wordt geïmplementeerd in de context van de EU AI Act. Het RMF is bedoeld om risico’s te identificeren, meten en af te vangen waar mogelijk. Door het creëren van de eerder genoemde AI Fairness checklist is Textkernel daar, samen met een aantal andere bedrijven, voorloper in door ervoor te zorgen dat je altijd ruimschoots voldoet aan de standaarden.

Het proces

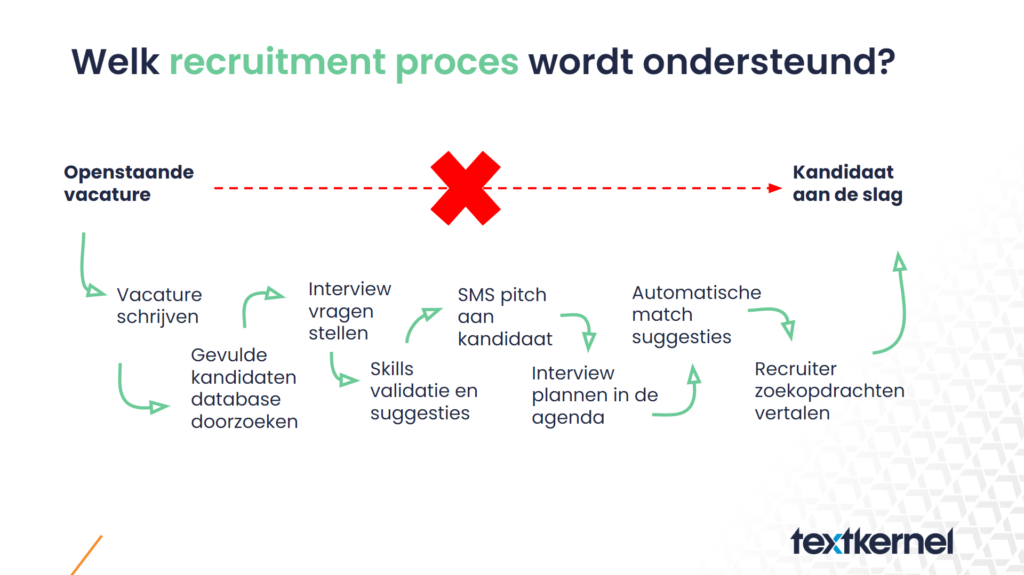

Een van de grootste valkuilen in het automatiseren van een reeks van meerdere taken is het sneeuwbaleffect. Daarmee bedoelen we dat hoe meer stappen van het volledige recruitmentproces je achter elkaar automatiseert, hoe meer het verlies aan transparantie zich ‘opstapelt’. Pas ermee op om niet het hele proces van begin tot eind door AI te laten overnemen, want er verdwijnt een stuk transparantie en nauwkeurigheid. Textkernel adviseert om ervoor te zorgen dat tijdens elke stap in het sollicitatieproces het AI-model taakgericht getraind wordt, zodat elke stap in het proces geen last heeft van het sneeuwbaleffect. Zo voorkom je dat foutieve output zonder menselijk toezicht effect heeft op de stappen die daarna komen en zorg je dat de accuraatheid en transparantie juist beter worden. Immers, je zorgt voor een AI model dat is getraind op een specifieke taak met een focus op juistheid aan de trainingsdata.

De controle

Uiteindelijk zoek je naar een oplossing waar de recruiter altijd de regie houdt. Dat betekent enerzijds dat je inzicht moet geven in hoe de resultaten tot stand zijn gekomen en dat je anderzijds de resultaten moet kunnen aanpassen, volledig verwijderen of zelf handmatig overnemen. Dat wordt ook wel een white box oplossing genoemd.

Om transparantie rondom AI in jouw bedrijf te waarborgen, is het van belang dat je weet hoe jouw data wordt gebruikt. Tevens is de juistheid van de data ontzettend belangrijk. Maar let hierbij op: meer data wil niet altijd zeggen dat het ook daadwerkelijk beter is. Als derde is het van belang om te zorgen dat jouw data een diverse en gebalanceerde representatie van de bevolking is. Als laatste moet je ervoor zorgen dat je altijd blijft voldoen aan de nieuwste regels en processen.

Responsible AI

Het gebruik van AI kan een tweesnijdend zwaard zijn. Het kan schade toebrengen als het onzorgvuldig wordt gebruikt, maar het kan ook eerlijkheid bevorderen en vooroordelen verminderen als het verantwoord wordt ingezet – wat cruciaal is voor het waarborgen van ethische resultaten. Bij Textkernel zijn we toegewijd aan het promoten van verantwoorde AI in werving en selectie, waarbij we ethische praktijken en inclusiviteit voorop stellen om de weg vrij te maken voor een betere, rechtvaardige toekomst.

Lees meer op onze pagina Responsible AI.